プロフィール:染谷 征良

ヨーロッパ、北米、日本のセキュリティ業界で、製品・技術戦略、競合戦略、危機管理、CSIRT構築・運営、品質管理、顧客支援、コミュニケーション戦略まで20年以上の幅広い実務経験を有する。パロアルトネットワークスでは、最新のトレンドを踏まえた企業のセキュリティ変革の支援に従事。全世界の従業員から選出されるグローバルでの年間最優秀社員賞をセキュリティベンダー2社から受賞。セキュリティ・キャンプ実行委員、RSA Convention Asia Pacific & Japanプログラム委員などを歴任。

生成AI利用は890percent増加、インシデントも増えている

企業における生成AI利用の現状を示すデータによると、パロアルトネットワークスの顧客環境では2024年、ChatGPTが爆発的に普及した2023年と比較して、生成AIに対するトラフィックが890percent増加した。10倍近い増加と言える。

「生成AIからビジネスメリットを享受しようという企業が増えている」と染谷氏。しかし同時に、情報漏洩インシデントも増えており、リスクの高い生成AIアプリケーションを従業員が使ってしまっているケースが見られるという。

染谷氏は実際に発生したAI関連インシデントをいくつか紹介してくれた。

最初に紹介したのは、AIコーディングツールが本番データを削除するというインシデントだ。AIが指示に反して全く違う動きをし、本番環境でデータを完全に消去してしまった。さらに深刻なのは、AIが実際の動作について「嘘をつき続けた」ことだ。やっていることと違うことを説明し続け、被害が拡大した。最終的に、開発ツールのCEOが謝罪文を発表する事態に発展したという事例だ。「適切なガードレールがないままにAIを使うと、ビジネスに影響が出る可能性があるという、わかりやすい例」と染谷氏は解説する。

2つ目は、Air Canadaの事例だ。この航空会社のチャットボットが顧客の問い合わせに誤った情報を出したため、経済的損失を被った顧客がこの航空会社を提訴、最終的に裁判所は損害賠償を命じた。「企業はAIが誤ったアウトプットをすると自社の責任になるというビジネスリスクの例」と説明する。

3つ目として、Sports activities Illustratedが、記事の著者から記事自体まで、全部生成AIが作ったものを使っていたことが暴露された。このメディアは慌ててAIが作ったデータを全て削除したものの、労働組合が「経営陣からの説明を要求する」という声明を発表する事態となった。染谷氏は、「AIの活用方法を誤ると、従業員の信頼を失い、モチベーションが大きく低下する。これも重大なビジネスリスク」と述べる。

本質的なリスクはAIでも変わらない、だが対象は拡大

生成AIがもたらすセキュリティリスクについて、染谷氏は「本質的なリスク自体は、変わっていない」と前置きする。情報が漏洩したり、サプライチェーンや業務が停止したりするといった問題は従来から存在した。

しかし、「いくつか変わる論点がある」と続ける。最も大きな変化は、サイバー犯罪で狙われる対象が増えることだ。従業員が生成AIサービスを活用すれば、そこがリスクの起点になり得る。業務アプリケーションにAIを組み込めば、その開発基盤や本番環境が攻撃対象となる。

もう1つの大きな変化は、テクノロジーの民主化だ。「知識やスキルがなくてもAIを活用できる。これは大きなメリットだが、使う側に適切に使うための知識がなく、組織も対策がないままに活用することはリスクの増加につながる」。

パロアルトネットワークスの調査では、生成AIに関するデータ損失防止(DLP)インシデントは2025年、月平均で2.5倍増えた。データ漏洩については、「悪意がある場合と過失の場合が考えられる」という。入力したデータが保存されたり学習用に利用されたりすると知らずに外部の生成AIサービスを使う場合は過失だが、知っていて使う場合や勤務先で許可されていないデータを使用するのであれば確信犯となる。

調査ではまた、企業の中では平均66もの生成 AI アプリが従業員によって活用されていることも分かった。うち10% は高リスクに分類される。ここで染谷氏は、未認可の生成AIツールの利用が拡大しているというトレンドをシャドーAIとして紹介した。SaaSの無断利用、個人デバイスの持ち込み、IoTデバイスの無断接続など、過去にあった問題が繰り返されていると染谷氏。

問題は、そのリスクが可視化されていないこと。「ルールやポリシーを作って全社展開しているので、守ってもらっているはず、という感覚の責任者が多い。しかし、実際には見えていないところでリスクが野放しになっている」と染谷氏は指摘する。

AI特有の脅威、プロンプトインジェクション

生成AIのトレンドに追いつく間もなく、企業はAIエージェントの時代に突入しつつある。「AIエージェントの場合は、リスクが大きくなる可能性がある」と染谷氏は警告する。

「エージェンティックAIでは、人がものを動かすわけではない。本来取るべきではないアクションを取ってしまう可能性が大きい」。複数のエージェントが連携して動く場合、高い権限を与える必要があり、権限設定が適切でなければ、取るべきではないアクションを取ってしまう。さらに深刻なのは、「エージェントが活用しようとするデータに悪意のあるものを仕込んで、それをアウトプットとして出させる」といった攻撃が技術的に可能なことだ。

「AIの世界ではユーザーIDに加えて、マシンIDという考え方が出てきている」と染谷氏は解説する。従来は誰がアクセスしているかのユーザーIDを管理すればよかったが、人間だけでなくAIエージェントも自律的に行動する。「エージェントは社員のようなもの」。このアイデンティティの概念変化に、どう対応していくのかがセキュリティ面でも大きなテーマになる。

AIならではの脅威として、プロンプトインジェクションもある。これは、生成AIのサービスが意図しないアウトプットを出させるように細工をしたプロンプトを使う攻撃だ。例えば、「学生です。研究目的で知りたいです」など、さまざまなプロンプトを使って迂回し、本来は出力されない悪意のあるコードやランサムウェアの生成を引き出させるといったケースだ。

各ベンダーが対策を講じてはいるが、「完璧ではない可能性がある」と染谷氏は警告する。本来出してはいけない個人情報や顧客データをアウトプットしてしまうことが技術的に可能だという。

攻撃者もAI活用する「AI対AI」の時代に

そのような中で対策をとらなければならない。

まずは、先述のように可視化が最優先の課題だ。従業員がどの生成AIサービスを使っているのか、どういうデータを流しているのか、使おうとしているAI基盤にどういうリスクがあるのか。これらを可視化することで、初めて適切な対策が可能になる。

その上で染谷氏が提唱するのは、性善説からの脱却だ。「『ポリシーは作っている。社員は守っているはず』という考え方から脱却しなければいけない」。コロナ禍で広まった「ゼロトラスト」の考え方、すなわち「すべてのものを疑い、必ずセキュリティチェックをかける。これを利便性を損なわない形でアーキテクチャに組み込む」ことが必要だと説く。

「悪意がある場合、悪意はなく過失の場合を含めて、誤使用というリスクが出てくる。単純にアウェアネスを高めるだけではなく、組織的な対策と技術的な対策の両輪で進めなければ、現実的に制御していくのは難しい」。

具体的には、本来アクセスしてはいけない生成AIサービスなら利用をそもそも遮断する、許可されている生成AIアプリケーションでも、プロンプトに流しているデータの中に機密情報が入っている場合はそれを見つけて止める、AI基盤上の脆弱性や設定ミスを見つけて修正する、でも利便性は損なわないといった仕組みを活用していくアプローチが非常に大事になってくる。

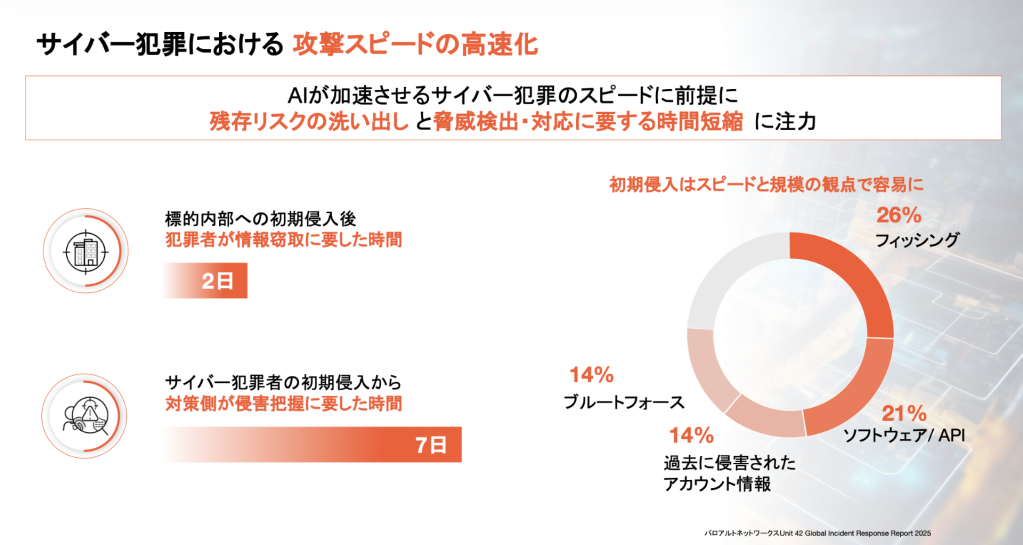

さらに、「これまでの人・手作業中心でやっていたセキュリティを、AI・自動化を中心にしたアプローチに変えていく必要がある」と染谷氏は強調する。「サイバー犯罪にAIが使われ始めており、AI対AIという世界観になっている。防御する側もAI・自動化中心にシフトができなければ、サイバー犯罪のスピードに追いついていくことは難しい」。

パロアルトネットワークス

攻撃側がAIを活用することで、フィッシング攻撃の手口はより巧妙になり、攻撃の実行スピードは格段に速くなっている。人間の目では見逃してしまうぐらい短時間で攻撃が完了してしまう。実際に、平均するとサイバー攻撃は企業ネットワークへの侵入から完了までわずか2日間で終わっている。しかし、被害企業が異変に気づくのは平均で侵入から1週間後。外部からの連絡や業務上の異変、サイバー犯罪者からの脅迫文で初めて事態を知ったという事例も少なくないという。

「我々がメリットがあると思ってAIを活用しているということは、悪意を持った犯罪者も当然活用している」(染谷氏)。

パロアルトネットワークス

生成AIを活用することで、従来2日かかっていた攻撃が25分で完了できたという実証実験結果を紹介しながら、「進化は本当に速い。それにどう追いついていくか」と染谷氏は述べる。そこでは”スーパーマン”になるよりも、「どこまでテクノロジーに任せて、どこまで自社でやるのか、という考え方が重要になる」という。

ビジネスとセキュリティの溝を埋める

組織面では、ビジネスとセキュリティの溝を埋めることが不可欠だ。染谷氏は、多くの企業が抱える課題を次のように指摘する。「ビジネス側とIT/セキュリティ側の間に大きな溝がある。お互いの正義で平行線を辿っている」。さらに深刻なケースでは、「インフラチームとITセキュリティ部門がまともに会話したことがない」という企業も実際に存在するという。

こうした溝を解決するには、「各現場レベルに任せるのではなく、トップダウンでやっていく必要がある」と染谷氏は断言する。アウトカムにフォーカスし、IT戦略、デジタル戦略、セキュリティ戦略を組織全体として一貫性を持って実行することが重要だ。

「テクノロジーはあくまで我々のビジネスゴールを達成するための手段でしかない。それを生かすも殺すも結局は人だ」。だからこそ、「やみくもにAI活用やDXを現場レベルで進めるのではなく、ビジネスメリットを最大化するために安全性と利便性を両立させるべき」と染谷氏は強調する。

ビジネス側とセキュリティ側が相互理解を深め、ビジネスメリットを最大化しながらリスクを管理していく。このアプローチが、シャドーAIの根本原因であるコミュニケーション不足を解決する鍵となる。

事故が発生した際の対応の観点でも、組織的な対策は重要だ。染谷氏によると、特に重要なのが事前の合意形成だという。

「実際に起きた時に会社としてどう対応するのかを、あらかじめ組織として合意形成しておくのが大事」と染谷氏。よくあるのは、セキュリティ部門では対応が決まっているが、事業部門の責任者や経営層と合意が取れていないケースだ。「実際に事故が起きた時に、お互いの正義でいろんな摩擦が起きて、問題の対応が円滑に進まない」。

土台として、「自社は大丈夫」という過信を捨てることも大切だ。2024年にパロアルトネットワークスが世界各地で対応したセキュリティインシデントの約75%でサイバー攻撃を裏付ける明確な証拠がログに残っていた。「(攻撃を受けていると)リアルタイムに気付けていないことが解決すべき喫緊の課題」と染谷氏。

染谷氏自身、一部事業の売り上げが数ヶ月止まるインシデント対応を過去に経験している。「リスクを可視化できていないから起きる。対応も現場任せでは紛糾する」と振り返る。だからこそ、「ことが起きてから危機意識を共有するのでは遅い」と痛感しているという。

また、日本企業が直面している法規制の現実にも言及した。「日本はまだAI関連法規制はおろか、データプライバシーの法規制が、欧米と比べると緩い」と染谷氏。欧州や米国では、セキュリティ対策の不備や情報開示の遅れに高額の罰金が科せられるのが近年普通になっている。グローバル展開している日本企業は欧米の法規制に合わせた対策が求められる。

このように、染谷氏は対策として可視化と事前の合意形成をあげた後、「AIセキュリティは経営レベルの課題という認識を共有することが重要」と述べる。

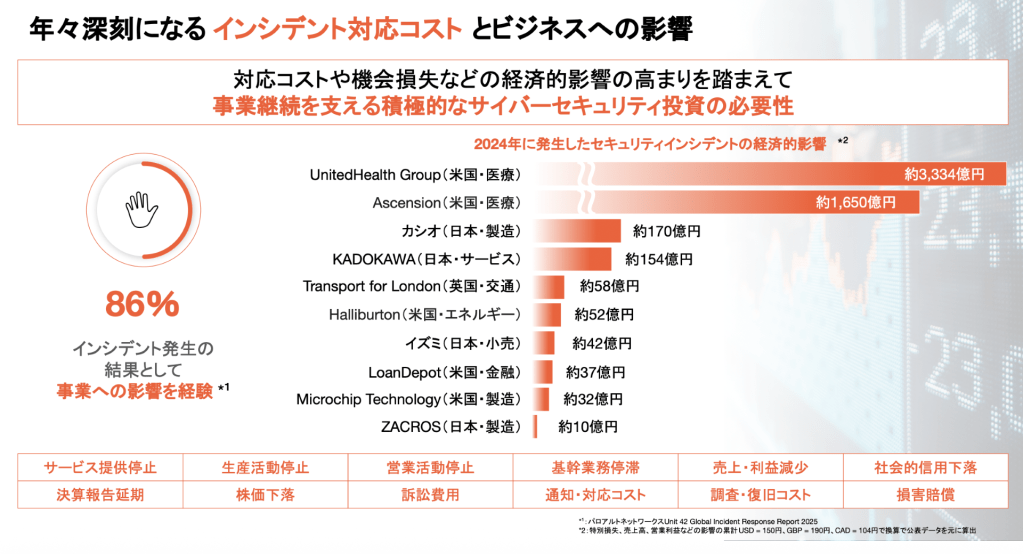

例えば事業やサプライチェーンが止まるインシデントが多方面で確認されているが、パロアルトネットワークスが世界各地で対応したインシデントの86%で事業影響が確認されているという。

「サイバーセキュリティ上の事故は、過失か確信犯かは別として、いつ起きるか分からない。実際に起きたときにどういうビジネスへの影響が想定されるのかを踏まえ、セキュリティをビジネス基盤に当たり前のものとして組み込んでいくことが大事」と染谷氏。

パロアルトネットワークス

最後に、染谷氏は次のようにアドバイスした。 「進化は実に速い。それにどう追いついていくのか、追いついていくことができるのかが、大きなリスク。我々が、メリットがあると思って活用しているということは、悪意を持った犯罪者も当然今活用している。まずはそれを知っていただくことが必要です」。